ASUS Tinker Edge Tでディープラーニングと推論を開始して実行できるように、この記事ではリアルタイムのポーズ検出を実行する方法をご紹介します。

PoseNetは、主要な身体の関節がどこにあるかを推定することにより、画像またはビデオ内の人物のポーズを決定するために使用できるビジョンモデルです。このアルゴリズムは画像またはビデオに登場する人物を認証または識別しないことにご注意ください。

姿勢認証は、身体トレーニング、環境意識、人間とコンピュータの相互作用、監視システム、高齢者のヘルスケアなどの分野で広く適用されています。

転倒は、65歳以上の人々の致命的および非致命的なけがの主な原因です。転倒により、股関節骨折、骨折、頭部外傷が起こる可能性があります。ポーズ検出技術は、病院や医療スタッフが介護中の高齢患者がいつベッドから出たり椅子から立ち上がりたいかを知るのに役立つ可能性があるので、時間内に支援できるようになります。この技術は人員不足の病院やヘルスケアセンターで特に役立ちます。

Google PoseNetはTinker Edge Tの画像に基づいて構築されています。使用方法については、続けてお読みください。

はじめに、以下に示すようなUSBカメラをTinker Edge Tに接続します。

Tinker Edge Tの電源を入れ、以下の画像に示すように赤いボックスをクリックしてターミナルを起動します。

ターミナルで次のコマンドを入力してプロジェクトディレクトリに移動し、PoseNetからカメラの画像をストリーミングし、画像にオーバーレイとしてポーズを描画する簡単なカメラの例を実行します。

$ cd /usr/share/project-posenet

$ python3 pose_camera.py --videosrc=/dev/video2

The argument --videosrc specifies the source of the camera image. In this example, /dev/video2 is the USB camera we just connected. For more information about available arguments, type -h follwing the command as shown below.

$ python3 pose_camera.py -h

usage: pose_camera.py [-h] [--mirror] [--model MODEL]

[--res {480x360,640x480,1280x720}] [--videosrc VIDEOSRC]

[--h264]

optional arguments:

-h, --help show this help message and exit

--mirror flip video horizontally (default: False)

--model MODEL .tflite model path. (default: None)

--res {480x360,640x480,1280x720}

Resolution (default: 640x480)

--videosrc VIDEOSRC Which video source to use (default: /dev/video0)

--h264 Use video/x-h264 input (default: False)

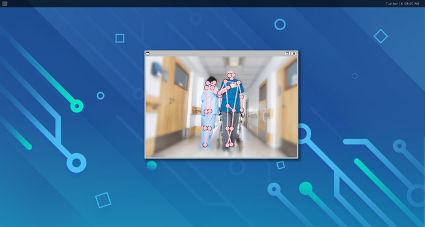

After successfully running the example project, you should see an image similar to the ones shown below..

詳細については、https://github.com/google-coral/project-posenet.を参照してください。