為了幫助您在ASUS Tinker Edge T上進行深度學習和推理,您可以使用它,本文將向您展示如何執行實時姿勢檢測。

PoseNet是一種視覺模型,可用於通過估計關鍵人體關節的位置來確定圖像或視頻中人的姿勢。請注意,此算法無法識別或識別出現在圖像或視頻中的人。

姿勢識別已廣泛應用於體育鍛煉,環境意識,人機交互,監視系統和老年人保健等領域。

跌倒是65歲以上人群致命和非致命傷害的主要原因。跌倒會導致髖部骨折,骨折和頭部受傷。姿勢檢測技術有潛力幫助醫院和醫護人員知道所護理的老年患者何時想起床或躺下,以便他們及時提供幫助。這項技術在面對人員短缺的醫院和醫療中心特別有用。

Google PoseNet建立在Tinker Edge T圖像上。有關使用說明,請繼續閱讀。

首先,將USB攝像頭(如下圖所示)連接到Tinker EdgeT。

接通Tinker Edge T的電源,然後單擊紅色框,啟動終端,如下圖所示。

在終端中,鍵入命令以進目目錄並運行一個簡單的照相機示例,該示例通過PoseNet傳輸照相機圖像並將姿勢繪製為圖像上的疊加層。

$ cd /usr/share/project-posenet

$ python3 pose_camera.py --videosrc=/dev/video2

The argument --videosrc specifies the source of the camera image. In this example, /dev/video2 is the USB camera we just connected. For more information about available arguments, type -h follwing the command as shown below.

$ python3 pose_camera.py -h

usage: pose_camera.py [-h] [--mirror] [--model MODEL]

[--res {480x360,640x480,1280x720}] [--videosrc VIDEOSRC]

[--h264]

optional arguments:

-h, --help show this help message and exit

--mirror flip video horizontally (default: False)

--model MODEL .tflite model path. (default: None)

--res {480x360,640x480,1280x720}

Resolution (default: 640x480)

--videosrc VIDEOSRC Which video source to use (default: /dev/video0)

--h264 Use video/x-h264 input (default: False)

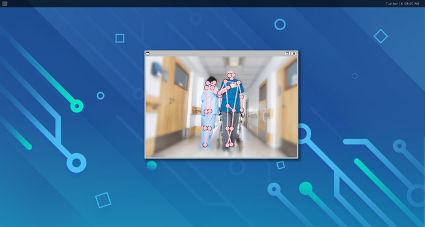

After successfully running the example project, you should see an image similar to the ones shown below..